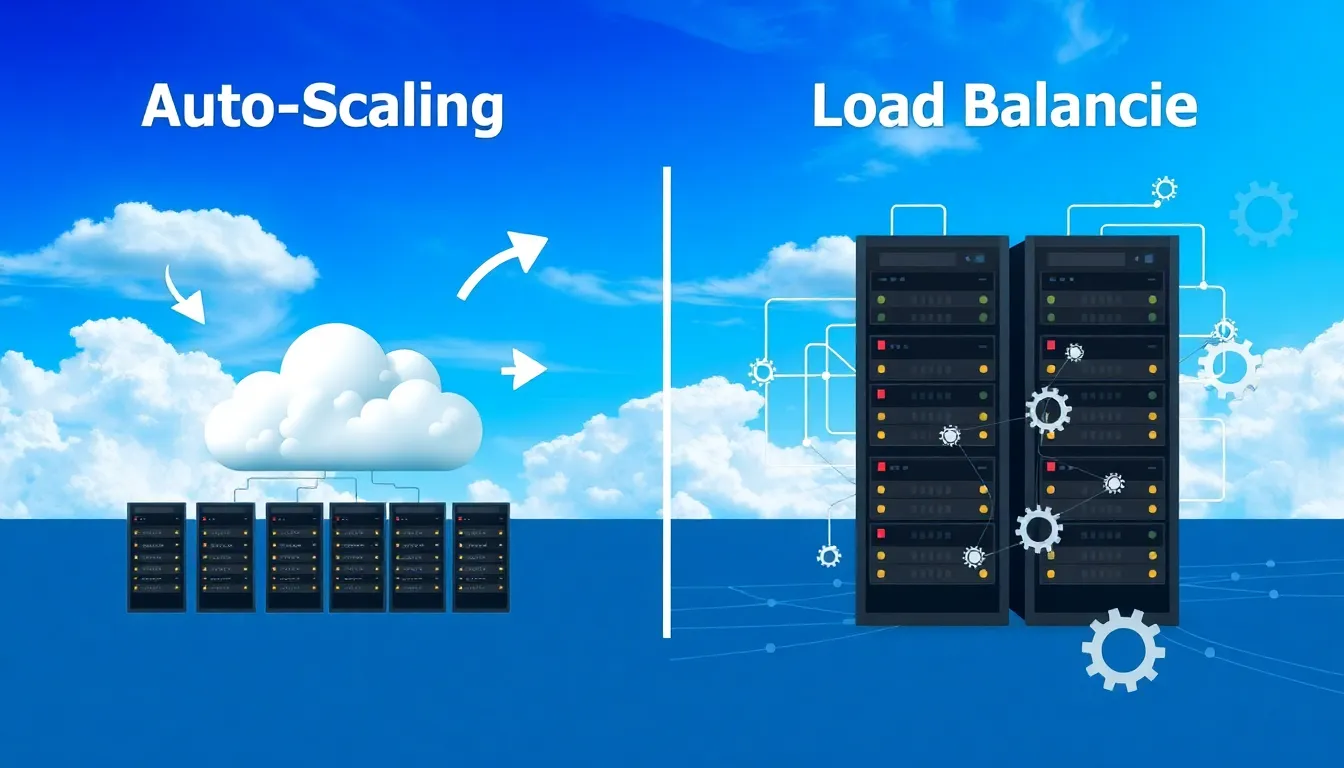

Auto-Scaling und Load Balancing bieten Unternehmen die nötige Flexibilität, ihre Cloud-Kapazitäten dynamisch an aktuelle Anforderungen anzupassen – ohne manuelle Eingriffe und mit starker Kostenkontrolle. Während Auto-Scaling die Skalierung der Ressourcen übernimmt, sorgt Load Balancing dafür, dass der eingehende Traffic leistungsfähig verteilt wird.

Zentrale Punkte

- Auto-Scaling automatisiert Ressourcenerweiterung und -reduzierung anhand von Echtzeitmetriken

- Load Balancing verteilt eingehenden Datenverkehr intelligent auf verfügbare Server

- Kombination aus beiden Ansätzen steigert Performance, Kostenkontrolle und Verfügbarkeit

- Szenarien: Optimal für E-Commerce, SaaS-Plattformen, APIs und Medien-Streaming

- Technologien: Unterstützt durch Cloud-Anbieter wie AWS, Azure und Google Cloud

Was bedeutet Auto-Scaling in der Cloud?

Auto-Scaling bedeutet, dass ein System automatisch zusätzliche Serverressourcen bereitstellt oder reduziert – je nachdem, ob gerade eine hohe oder geringe Auslastung besteht. Moderne Cloud-Plattformen wie AWS oder Google Cloud nutzen Metriken wie CPU-Auslastung, Arbeitsspeicher-Nutzung oder Netzwerk-Latenz, um Entscheidungen zur Kapazitätsanpassung treffen zu können.

Durch Auto-Scaling lassen sich unnötige Kosten vermeiden, da nur dann Ressourcen laufen, wenn diese benötigt werden. Besonders bei stark schwankender Nachfrage wie saisonalen Verkäufen oder viralen Nutzeranstiegen bewährt sich diese Methode. Auch in einer serverlosen Architektur wie AWS Lambda spielt Auto-Scaling eine entscheidende Rolle, da Funktionen dynamisch skaliert werden.

Die Vorteile gehen über die Kostenersparnis hinaus: Anwendungen bleiben performant, unabhängig vom Verkehrsaufkommen. Ebenso steigt die Systemstabilität, da Engpässe frühzeitig erkannt und automatisch ausgeglichen werden. In Verbindung mit Monitoring-Tools können Skalierungsvorgänge präzise nachverfolgt werden.

Funktionsweise von Load Balancing

Load Balancing verteilt eingehenden Datenverkehr gleichmäßig auf mehrere Server oder Services. Dabei kommen unterschiedliche Algorithmen zum Einsatz: etwa Round Robin (abwechselnde Verteilung), Least Connections (Server mit geringster Last) oder IP-Hashing (auf Basis der IP-Adresse des Nutzers).

Diese Technik verhindert, dass einzelne Knoten überlastet werden, und sichert die Verfügbarkeit der Systeme. In hochverfügbaren Architekturen wie Content-Delivery-Netzwerken (CDNs) ist Load Balancing essenziell, um eine gleichbleibende Latenz weltweit sicherzustellen. Die meisten Cloud-Load-Balancer beinhalten zudem Health-Checks, mit denen fehlerhafte Server automatisch vom Traffic ausgeschlossen werden.

Mit strategischem Lastenausgleich arbeite ich effizienter, vermeide Systemabstürze und reagiere gezielt auf Ausfälle. Im Zusammenspiel mit Auto-Scaling ergibt sich ein Cloud-System, das sich selbstständig anpasst und dennoch kontrollierbar bleibt.

Vergleich von Auto-Scaling und Load Balancing

Beide Konzepte verfolgen unterschiedliche Aufgaben innerhalb der Cloud-Architektur und lassen sich ergänzend einsetzen. In dieser Tabelle wird der direkte Funktionsvergleich deutlich:

| Kriterium | Auto-Scaling | Load Balancing |

|---|---|---|

| Funktion | Automatisches Erhöhen oder Reduzieren von Serverkapazitäten | Verteilung des eingehenden Datenverkehrs auf mehrere Server |

| Zweck | Skalierbarkeit und Kosteneffizienz | Stabilität und Ausfallsicherheit |

| Auslöser | Systemmetriken wie CPU-Auslastung | Laufender Nutzer-Traffic |

| Technische Umsetzung | Virtuelle Maschinen oder Container | Virtuelle oder Hardware-basierte Load Balancer |

Welche Vorteile entstehen durch die Kombination?

Die Kombination aus Auto-Scaling und Load Balancing bringt erhebliche Leistungsgewinne mit sich. Während das eine Konzept die Kapazitäten dynamisch anpasst, sorgt das andere für optimalen Traffic-Fluss. So bleiben Systeme schnell, skalierbar und verfügbar – auch zu Stoßzeiten.

In der Praxis zeigt sich dieser Vorteil deutlich: Eine Mediathek mit Video-Streaming kann bei steigendem Nutzeraufkommen zusätzliche Container skalieren und gleichzeitig Viewer-Anfragen gezielt auf die leistungsfähigsten Knotenpunkte verteilen. Gleiches gilt auch für APIs oder SaaS-Lösungen. Load Balancer übernehmen die Lastverteilung, Auto-Scaling stellt die nötigen Ressourcen sicher.

Ich greife hier oft auf Containerbasierte Systeme zurück, die sich gemeinsam mit intelligentem Traffic Management automatisch anpassen und wieder verkleinern lassen, sobald die Auslastung abnimmt.

Einsatzszenarien für dynamische Cloud-Architekturen

Auto-Scaling und Load Balancing eignen sich für unterschiedlichste Anwendungen: von E-Commerce über Unternehmensportale bis hin zu mobilen Spielen oder datenintensiven Analyseplattformen. Besonders profitabel ist diese Kombination bei Traffic-Schwankungen, internationalen Audiences und schnell wachsenden Nutzerzahlen.

In folgenden Szenarien bieten sich deutliche Vorteile:

- E-Commerce-Plattformen mit saisonalen Verkaufsspitzen

- Live-Streaming-Services mit plötzlichem Zuschaueranstieg

- Microservice-Architekturen mit modularer Ressourcenverteilung

- Serverless-Funktionen mit Ereignis-basierten Ausführungen

Ich empfehle bei jedem Projekt genaue Monitoring-Strategien und klar definierte Trigger für Skalierungen, um Automatisierungen sinnvoll und kontrolliert zu nutzen.

Technologischer Hintergrund und Anbieter

Verschiedene Cloud-Anbieter setzen ihre eigenen Methoden zur Implementierung von Auto-Scaling und Load Balancing um. So bietet AWS mit Elastic Load Balancing (ELB) und Auto Scaling Groups eine kombinierbare Konfiguration. Google Cloud bevorzugt hingegen HTTP(S)-Load-Balancing mit regionalem Autoscaling.

Auch Open Source Lösungen – etwa Kubernetes mit Horizontal Pod Autoscaler und Ingress-Controllern – ermöglichen eine detaillierte Steuerung. Wichtig ist, dass die Architektur modular und zukunftssicher entworfen wird, um flexibel auf Marktveränderungen zu reagieren.

Ich setze je nach Projektvolumen sowohl auf Third-Party-Lösungen als auch native Services der Plattform. Entscheidende Kriterien sind Monitoring-Support, Skalierungslatenz und Preismodelle. Vor allem die Pay-as-you-go-Modelle erweisen sich als effizient.

Weiterführende Praxisempfehlungen

Wer sich langfristig mit Auto-Scaling und Load Balancing befasst, erkennt schnell die Bedeutung einer ausgereiften Planungsphase. Ich beginne in der Regel mit der Analyse der zu erwartenden Spitzenlasten, bevor ich mich mit konkreten Implementierungsdetails befasse. Wichtig ist, die richtigen Metriken auszuwählen und entsprechende Schwellenwerte zu definieren. Oft reichen CPU- oder RAM-Nutzung nicht aus; in vielen Fällen sagt die Antwortzeit einer Anwendung, der Datendurchsatz oder sogar benutzerdefinierte Business-Kennzahlen weit mehr über den tatsächlichen Ressourcenbedarf aus.

Um präzise zu skalieren, setze ich häufig auf mehrstufige Alarme. So etwa wird zunächst ein Warnlevel definiert, bei dem ich eine Benachrichtigung erhalte. Sollte die Last weiter steigen, kann ein zweiter Trigger folgen, der das Hinzufügen von zusätzlichen Ressourcen initiiert. Das verhindert unnötiges Hin- und Herskalieren, das bei sensiblen Anwendungen teilweise sogar zu Kostenanstiegen führen kann. Insbesondere bei Cloud-Projekten, die sehr schnell wachsen, ist es hilfreich, die Skalierungsregeln zunächst konservativ einzustellen und sie mit wachsendem Erfahrungswert zu optimieren.

Best Practices bei der Implementierung

Um die Zusammenarbeit zwischen Auto-Scaling und Load Balancing zu maximieren, setze ich auf ein klares Ummappen von DNS-Einträgen und eine automatisierte Provisionierung der Serverinstanzen. Continuous Integration und Continuous Deployment (CI/CD) bilden in diesem Zusammenhang oft das Rückgrat der Infrastruktur. Für Load Balancer ist es empfehlenswert, Health Checks eng mit dem Deployment-Prozess zu verzahnen, damit neue Instanzen erst dann in den Traffic-Strom eingebunden werden, wenn sie vollständig hochgefahren und stabil sind.

Eine weitere Best Practice ist die Einbindung von Canary-Releases: Neue Versionen einer Anwendung werden erst für einen kleinen Teil des Nutzer-Traffics freigegeben und können so bei Problemen schnell aus dem Verkehr gezogen werden. Dadurch verteile ich das Änderungsrisiko und erhalte frühzeitig Feedback. Kommt es zu Ausfällen, lässt sich die entsprechende neue Version automatisch aus dem Load Balancer entfernen, während das Auto-Scaling in der Zwischenzeit den Bestand deiner bewährten Instanzen wieder hochfährt. So reduziere ich Ausfallzeiten auf ein Minimum.

Typische Stolperfallen und wie man sie vermeidet

Einer der häufigsten Fehler besteht darin, das Monitoring zu vernachlässigen. Ohne verlässliche Datenbasis werden Skalierungsentscheidungen blind getroffen und führen unter Umständen zu wilden Auf- und Abschwüngen. Das kann in unnötigen Kosten resultieren und die Anwender-Performance beeinträchtigen. Daher ist ein durchgängiges Observability-Konzept ratsam, das sowohl Logs als auch Metriken (z. B. CPU, RAM, Netzwerk, Latenz) sammelt und korreliert. Auch das Einbeziehen von Distributed Tracing für Microservices-Architekturen bietet sich an, um Engpässe schnell zu identifizieren.

Ein weiterer Stolperstein findet sich bei der zu knappen Wortrate: Oft wird vergessen, dass das Hinzufügen neuer Server einige Sekunden bis Minuten beanspruchen kann. In sehr volatilen Umgebungen – beispielsweise bei Ticketverkäufen für Events – muss man damit rechnen, dass eine plötzliche Trafficspitze nicht aufgefangen wird, wenn die Skalierungsvorgaben zu konservativ eingestellt sind. Hier helfen vordefinierte Warm Pools oder Reservierungen bei Cloud-Anbietern, sodass die Systeme in einem Standby-Modus schlummern und schnell aktiviert werden können, ohne erst eine frische VM hochzufahren.

Integration in DevOps-Prozesse

In vielen Projekten arbeite ich eng mit DevOps-Prinzipien, um die Vorteile von Auto-Scaling und Load Balancing voll auszuschöpfen. Dabei ist Kollaboration zwischen Development und Operations essenziell. Werden Änderungen am Code durchgeführt, sollten Deployments automatisiert ablaufen. Gleichzeitig sollte die Infrastruktur definitionsgetrieben sein, beispielsweise via Infrastructure-as-Code. Das erlaubt mir, Load-Balancerkonfigurationen und Auto-Scaling-Regeln in Versionskontrollsystemen abzubilden und Änderungen transparent nachvollziehbar zu machen.

Darüber hinaus empfehle ich in DevOps-Umgebungen eine enge Verzahnung mit Monitoring-Lösungen wie Prometheus oder proprietären Angeboten der jeweiligen Cloud-Plattform. Nur so erfährt das Team zeitnah, wenn Skalierungsgrenzen überschritten werden oder wenn eine fehlerhafte Einstellung des Load Balancers für Engpässe sorgt. Durch das gemeinsame Verständnis von Code und Infrastruktur wird das Troubleshooting deutlich vereinfacht und eskalierende Probleme lassen sich frühzeitig abfangen.

Kostenoptimierung und Budgetkontrolle im Blick

Auto-Scaling ist zwar prädestiniert für Kosteneffizienz, doch kann ein unüberlegtes Skalieren genau das Gegenteil bewirken. Wird zu schnell hochskaliert, fallen unnötige Gebühren an. Ich setze daher gerne auf Modelle, die neben der reaktiven Skalierung auch Planungen für vorhersehbare Lasten zulassen. So kann ich beispielsweise nachts automatisch Server abschalten, wenn ich genau weiß, dass um diese Zeit kaum Nutzer aktiv sind. Ebenso kann ich mir Reserved Instances oder Spot Instances zunutze machen, um dauerhaft günstige Tarife zu sichern.

Beim Load Balancing besteht ein weiteres Kostenelement in den Datenübertragungskosten. Jeder Traffic, der zwischen Load Balancer und Servern fließt, kann in bestimmten Cloud-Umgebungen Gebühren verursachen. Deshalb empfiehlt sich eine Struktur, bei der möglichst viele Ressourcen in derselben Availability Zone oder Region liegen, um unnötigen Datentransfer zu reduzieren. Auch das strategische Platzieren von Caching-Lösungen direkt zwischen Load Balancer und Applikation kann helfen, die effektiv zu verarbeitende Datenmenge zu reduzieren und dadurch Kosten zu senken.

Sicherheitsaspekte bei skalierenden Infrastrukturen

Ein gerne übersehener Punkt ist die Sicherheit. Werden Auto-Scaling-Gruppen verwendet, müssen auch Sicherheitsgruppen und Netzwerkzugriffslisten dynamisch mithalten können. Andernfalls riskiere ich, dass neu hinzukommende Instanzen nicht mit den korrekten Firewall-Regeln ausgestattet werden und potenzielle Angriffspunkte bilden. Dasselbe gilt für die Zertifikatsverwaltung bei Load Balancern, etwa im HTTPS-Umfeld. Ich empfehle daher, Sicherheitsrichtlinien ebenfalls als Code zu definieren, damit sie jederzeit reproduzierbar sind.

Datenschutz lässt sich mithilfe von verschlüsselten Verbindungen und sicheren Token-Mechanismen wahren. Wichtig ist, dass bei skalierender Infrastruktur jede zusätzliche Instanz dieselben Kryptoschlüssel oder Zertifikate nutzt, sodass keine Lücke im Authentifizierungsprozess entsteht. Dennoch sollte man den Grundsatz der minimalen Rechtevergabe beachten und neuen Instanzen nur die Zugriffsrechte einräumen, die sie konkret benötigen. Auf diese Weise bleibt die Angriffsfläche klein, auch wenn sich die Infrastruktur dynamisch verändert.

Zukünftige Entwicklungen und Trends

Die Konzepte von Auto-Scaling und Load Balancing entwickeln sich stetig weiter. Mit dem Vormarsch von serverlosen Plattformen und Edge-Computing rücken neue Verteilungsmuster in den Fokus. Ressourcen können dadurch näher an den Endnutzer verlagert werden, was Latenzen senkt. Gleichzeitig spielen automatisierte Load Balancer in globalen Netzwerken eine immer größere Rolle, um nicht nur innerhalb einer Region zu verteilen, sondern weltweit.

Die wachsende Bedeutung von KI und Machine Learning für Predictive Scaling ist ein spannender Trend: Anstatt rein reaktiv zu skalieren, prognostizieren entsprechende Algorithmen das künftige Nutzerverhalten. So kann man Ressourcen rechtzeitig in Betrieb nehmen, bevor Lastspitzen tatsächlich eintreffen. Das vermeidet Wartezeiten beim Hochfahren neuer Instanzen und sorgt für ein noch reibungsloseres Nutzungserlebnis. Ich rechne damit, dass in den kommenden Jahren immer mehr Anbieter strategische Partnerschaften eingehen, um die Cloud-Bereitstellung mithilfe von KI zu automatisieren und zu optimieren.

Erkenntnisse zum Abschluss

Auto-Scaling und Load Balancing bieten eine verlässliche Antwort auf volatile Nutzungszahlen und Betriebsanforderungen. Sie sichern die Leistungsfähigkeit technischer Infrastrukturen, verringern Kostenrisiken und helfen, den operativen Cloud-Betrieb zu automatisieren.

Wer langfristig effizient arbeiten will, sollte beide Technologien nicht isoliert betrachten. Eine Kombination aus dynamischer Skalierung und intelligenter Lastverteilung bietet klare Vorteile – sowohl technisch als auch wirtschaftlich. Ich nutze diese Strategien regelmäßig, um Cloud-Infrastrukturen resilient und anpassbar zu halten.

Mit einem passenden Monitoring-Stack, vorher geplanten Skalierungsregeln und modernen DevOps-Praktiken lassen sich Betriebskosten senken und gleichzeitig die Endnutzererfahrung verbessern.